Hugging Face Pipelines procesa datos con IA

- ¿Cómo Hugging Face Pipelines utiliza IA para procesar datos?

- ¿Qué se puede hacer en Hugging Face?

- ¿Qué tipo de aplicaciones se pueden crear con los spaces de Hugging Face?

- ¿Dónde se guardan los modelos de Hugging Face?

- ¿Cuál es el tamaño de lote predeterminado en la canalización de Huggingface?

- Mas Información sobre este tema

En el mundo actual, el procesamiento de datos mediante inteligencia artificial se ha convertido en una herramienta indispensable. Hugging Face, una plataforma líder en el campo del machine learning, ofrece soluciones eficientes a través de sus pipelines. Estas herramientas permiten a desarrolladores y empresas integrar modelos preentrenados de manera sencilla, optimizando tareas como el análisis de texto, la traducción automática o la generación de contenido.

Los pipelines de Hugging Face destacan por su facilidad de uso y versatilidad, eliminando barreras técnicas para acceder a tecnología avanzada de IA. Con solo unas líneas de código, es posible procesar grandes volúmenes de información, adaptándose a diversas necesidades. Esta capacidad democratiza el acceso a la inteligencia artificial, impulsando la innovación en múltiples sectores.

Te puede interesar leer: Appian AI automatiza procesos con IA simple

¿Cómo Hugging Face Pipelines utiliza IA para procesar datos?

Hugging Face Pipelines es una herramienta poderosa que simplifica el procesamiento de datos mediante modelos de inteligencia artificial preentrenados. Estas canalizaciones permiten a los desarrolladores ejecutar tareas complejas, como análisis de texto, traducción automática o generación de contenido, con solo unas pocas líneas de código. La integración de IA en Pipelines acelera el flujo de trabajo y reduce la necesidad de configuraciones manuales. Además, su arquitectura modular facilita la adaptación a diferentes necesidades, desde proyectos pequeños hasta aplicaciones empresariales.

Ventajas de usar Hugging Face Pipelines en el análisis de datos

Una de las principales ventajas de Hugging Face Pipelines es su capacidad para procesar grandes volúmenes de datos de manera eficiente. Gracias a modelos preentrenados como BERT o GPT, es posible realizar tareas avanzadas sin necesidad de entrenar un modelo desde cero. Además, su compatibilidad con múltiples lenguajes y formatos lo hace ideal para proyectos internacionales. La siguiente tabla resume algunas de sus ventajas clave:

| Ventaja | Descripción |

|---|---|

| Rapidez | Procesamiento casi instantáneo gracias a modelos optimizados. |

| Facilidad de uso | Interfaz simplificada que requiere mínima configuración. |

| Escalabilidad | Capacidad para manejar desde pequeños conjuntos de datos hasta big data. |

Casos de uso comunes de Hugging Face Pipelines en IA

Hugging Face Pipelines se utiliza en una amplia variedad de aplicaciones prácticas. Por ejemplo, en el campo del procesamiento de lenguaje natural (NLP), es ideal para tareas como clasificación de texto, resumen automático o detección de emociones. También es útil en la generación de contenido automatizado y en la traducción entre idiomas. Su versatilidad lo convierte en una herramienta esencial para empresas y desarrolladores que trabajan con datos textuales. A continuación, algunos ejemplos destacados:

| Caso de uso | Aplicación |

|---|---|

| Análisis de sentimientos | Evaluar opiniones en redes sociales o reseñas de productos. |

| Traducción automática | Convertir texto entre múltiples idiomas con alta precisión. |

| Generación de respuestas | Crear chatbots inteligentes para servicio al cliente. |

Configuración básica de una Pipeline en Hugging Face

Para comenzar a usar Hugging Face Pipelines, solo se necesitan unos pocos pasos. Primero, es necesario instalar la biblioteca Transformers de Hugging Face. Luego, se selecciona el modelo preentrenado adecuado para la tarea deseada, como 'text-classification' o 'text-generation'. La configuración inicial es intuitiva, lo que permite a los usuarios enfocarse en el análisis de datos en lugar de en detalles técnicos. Aquí hay un resumen de los pasos básicos:

| Paso | Descripción |

|---|---|

| Instalación | Ejecutar pip install transformers en la terminal. |

| Importar Pipeline | Usar from transformers import pipeline en el código. |

| Cargar modelo | Crear una instancia con pipeline(tarea, model=nombre-del-modelo). |

¿Qué se puede hacer en Hugging Face?

Explorar y utilizar modelos de inteligencia artificial

En Hugging Face, puedes acceder a una amplia variedad de modelos preentrenados de inteligencia artificial, especialmente en áreas como procesamiento de lenguaje natural (NLP), visión por computadora y generación de audio. Estos modelos están disponibles para su uso inmediato o para personalización según tus necesidades. Algunas acciones clave incluyen:

- Descargar modelos como GPT, BERT o Stable Diffusion para integrarlos en tus proyectos.

- Probar modelos directamente en la plataforma mediante interfaces interactivas sin necesidad de código.

- Fine-tuning: ajustar modelos preentrenados con tus propios datos para tareas específicas.

Compartir y colaborar en proyectos de machine learning

La plataforma funciona como un hub comunitario donde investigadores y desarrolladores pueden compartir sus modelos, datasets y aplicaciones. Esto facilita la colaboración y el avance en el campo del machine learning. Algunas opciones destacadas son:

- Subir modelos propios para que otros usuarios los utilicen o mejoren.

- Publicar datasets etiquetados o procesados para entrenar modelos.

- Colaborar en espacios de trabajo (Spaces) para desarrollar aplicaciones demos con equipos.

Desarrollar y desplegar aplicaciones con IA

Hugging Face ofrece herramientas para crear y desplegar aplicaciones basadas en IA de forma sencilla, incluso sin conocimientos avanzados en programación. Entre las posibilidades se encuentran:

- Crear demos interactivas con Gradio o Streamlit para mostrar el funcionamiento de modelos.

- Desplegar APIs para integrar modelos en servicios web o aplicaciones móviles.

- Utilizar Inference API para ejecutar modelos en la nube sin gestionar infraestructura.

¿Qué tipo de aplicaciones se pueden crear con los spaces de Hugging Face?

Aplicaciones de procesamiento de lenguaje natural (NLP)

Con los Spaces de Hugging Face, puedes desarrollar aplicaciones avanzadas de procesamiento de lenguaje natural (NLP), aprovechando modelos preentrenados como GPT, BERT o T5. Estas aplicaciones pueden incluir:

- Traductores automáticos que convierten texto entre múltiples idiomas en tiempo real.

- Asistentes virtuales capaces de responder preguntas o generar contenido basado en prompts.

- Análisis de sentimientos para evaluar emociones en reseñas, redes sociales o comentarios.

Aplicaciones de visión por computadora

Los Spaces también permiten crear herramientas de visión por computadora utilizando modelos como YOLO o ViT. Algunos ejemplos incluyen:

- Reconocimiento de objetos en imágenes o videos para uso en seguridad o retail.

- Clasificación de imágenes automática, como identificar plantas, animales o productos.

- Generación de arte mediante IA, como convertir bocetos en imágenes detalladas.

Aplicaciones de audio y voz

Otra área destacada son las aplicaciones de procesamiento de audio, con modelos como Whisper o Wav2Vec. Entre las posibilidades están:

- Transcripción automática de audios a texto para reuniones o podcasts.

- Síntesis de voz que convierte texto en habla con tonos naturales.

- Reconocimiento de comandos para controlar dispositivos mediante voz.

¿Dónde se guardan los modelos de Hugging Face?

Los modelos de Hugging Face se guardan en el Hugging Face Hub, un repositorio en línea donde los usuarios pueden almacenar, compartir y descargar modelos de machine learning. También pueden almacenarse localmente en el directorio cache del sistema del usuario, generalmente en una carpeta llamada .cache/huggingface.

Ubicación predeterminada de los modelos en el sistema local

Los modelos descargados de Hugging Face se guardan automáticamente en una carpeta de cache en el sistema del usuario. La ubicación varía según el sistema operativo:

- Windows:

C:Users[usuario].cachehuggingfacehub - Linux/macOS:

~/.cache/huggingface/hub - Esta ruta puede modificarse configurando la variable de entorno HF_HOME.

Acceso y gestión de modelos en el Hugging Face Hub

El Hugging Face Hub es una plataforma centralizada donde los modelos se almacenan y comparten públicamente o de forma privada:

- Los modelos públicos pueden ser descargados por cualquier usuario mediante la biblioteca transformers.

- Los modelos privados requieren autenticación con un token de acceso.

- Los modelos pueden buscarse y filtrarse por tareas, frameworks y popularidad.

Personalización del almacenamiento de modelos

Es posible cambiar la ubicación de almacenamiento de los modelos para adaptarse a necesidades específicas:

- Usando la variable de entorno HF_HOME para definir una nueva ruta de cache.

- Descargando manualmente los modelos y cargándolos desde una ruta personalizada con

from_pretrained(). - Utilizando Hugging Face Datasets o Transformers para gestionar múltiples ubicaciones de almacenamiento.

¿Cuál es el tamaño de lote predeterminado en la canalización de Huggingface?

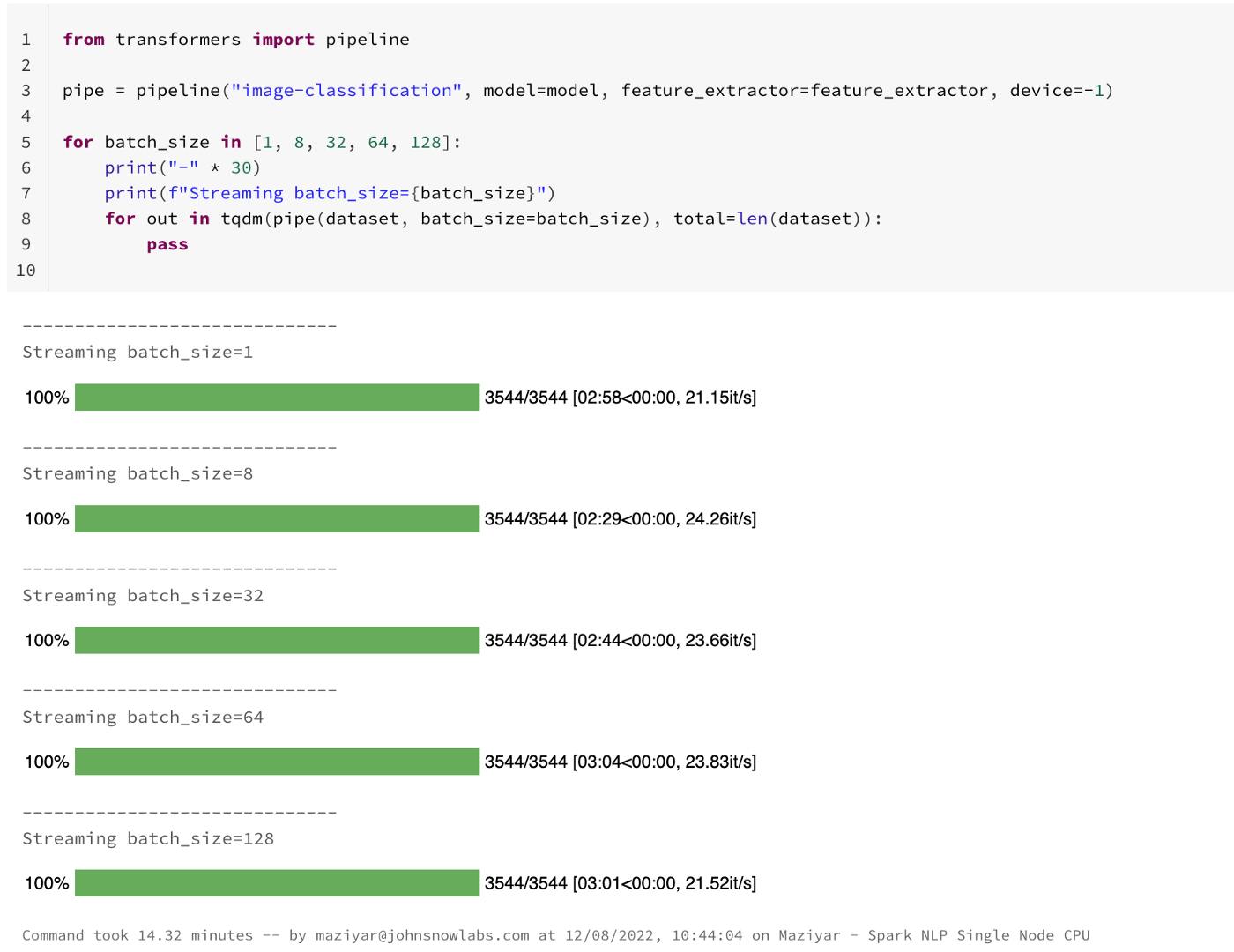

El tamaño de lote predeterminado en la canalización de Huggingface es 1. Esto significa que, por defecto, el modelo procesa una sola entrada a la vez, lo que garantiza compatibilidad con la mayoría de hardware, incluso en entornos con recursos limitados.

¿Por qué el tamaño de lote predeterminado es 1 en Huggingface?

El tamaño de lote predeterminado se establece en 1 para garantizar la máxima compatibilidad y evitar problemas de memoria en dispositivos con recursos limitados. Algunas razones clave incluyen:

- Compatibilidad universal: Funciona en entornos con poca RAM o GPU limitada.

- Prevención de errores: Evita excepciones por falta de memoria al procesar lotes grandes.

- Flexibilidad: Permite a los usuarios ajustar manualmente el tamaño según sus necesidades y hardware.

¿Cómo cambiar el tamaño de lote en Huggingface?

Para modificar el tamaño de lote en una canalización de Huggingface, se puede usar el parámetro batch_size. Ejemplo:

- Configuración básica: Añadir

batch_size=Xal crear la canalización. - Optimización: Ajustar según la capacidad de la GPU o CPU disponible.

- Precauciones: Verificar que el hardware soporte el nuevo tamaño para evitar errores.

Ventajas y desventajas de aumentar el tamaño de lote

Aumentar el tamaño de lote puede mejorar el rendimiento, pero también tiene implicaciones:

- Ventajas:

- Mayor velocidad de procesamiento al paralelizar cálculos.

- Mejor uso de recursos en GPUs potentes.

- Desventajas:

- Mayor consumo de memoria RAM/VRAM.

- Riesgo de errores si el hardware no es suficiente.

Mas Información sobre este tema

¿Qué tipos de tareas de procesamiento de datos puede realizar Hugging Face Pipelines con IA?

Hugging Face Pipelines es una herramienta versátil que permite realizar múltiples tareas de procesamiento de datos utilizando modelos de inteligencia artificial. Entre las tareas más comunes se incluyen el procesamiento de lenguaje natural (NLP), como traducción automática, generación de texto, análisis de sentimientos y reconocimiento de entidades nombradas. También soporta tareas de visión por computadora, como clasificación de imágenes y detección de objetos, así como procesamiento de audio, incluyendo reconocimiento de voz. La plataforma simplifica el uso de modelos preentrenados, haciendo que la integración de IA en flujos de trabajo sea más accesible.

¿Cómo se configuran y utilizan los Pipelines de Hugging Face para procesar datos?

Para utilizar los Pipelines de Hugging Face, primero es necesario instalar la biblioteca Transformers de Hugging Face mediante pip. Una vez instalada, puedes crear un pipeline específico para tu tarea (por ejemplo, text-classification o object-detection) utilizando una sola línea de código. La configuración básica implica seleccionar el modelo preentrenado adecuado y, opcionalmente, ajustar parámetros como el dispositivo de ejecución (CPU o GPU). Los pipelines están diseñados para ser intuitivos, permitiendo procesar datos de entrada (texto, imágenes o audio) y obtener resultados rápidamente sin necesidad de profundizar en detalles técnicos complejos.

¿Qué ventajas ofrece Hugging Face Pipelines frente a otras soluciones de IA?

La principal ventaja de Hugging Face Pipelines es su facilidad de uso y su integración con una amplia gama de modelos preentrenados de última generación. A diferencia de otras soluciones, no requiere conocimientos avanzados en machine learning para comenzar a procesar datos. Además, la plataforma ofrece una comunidad activa y documentación detallada, lo que facilita la resolución de problemas y la personalización de modelos. Otra ventaja clave es su escalabilidad, ya que permite desplegar pipelines en entornos de producción con relativa sencillez, optimizando el rendimiento mediante el uso de GPUs o TPUs cuando sea necesario.

Esto es de tu interes AllenNLP analiza texto con IA para programadores

AllenNLP analiza texto con IA para programadores Dask escala computación de IA con Python

Dask escala computación de IA con Python Modin acelera Pandas para datos de IA

Modin acelera Pandas para datos de IASi quieres conocer otros artículos parecidos a Hugging Face Pipelines procesa datos con IA puedes visitar la categoría IA para Desarrolladores.

Deja una respuesta

Contenido Relacionado