TorchScript optimiza código de IA con PyTorch

TorchScript, en el mundo del desarrollo de inteligencia artificial, la optimización del código es un factor clave para garantizar un rendimiento eficiente y escalable. PyTorch, una de las librerías más populares para el aprendizaje automático, ofrece TorchScript como una solución robusta para convertir modelos de Python en gráficos de ejecución independientes. Esta herramienta permite mejorar la velocidad de inferencia y facilita el despliegue en entornos donde la flexibilidad de Python puede ser un cuello de botella.

TorchScript no solo optimiza el rendimiento, sino que también simplifica la integración en plataformas móviles y embebidas. Al compilar modelos de PyTorch en un formato intermedio, se logra una mayor portabilidad sin sacrificar la precisión. Esto resulta especialmente útil en aplicaciones que requieren baja latencia o recursos limitados, consolidando a TorchScript como una opción indispensable para desarrolladores que buscan llevar sus proyectos de IA al siguiente nivel.

Te puede interesar leer: ContentBot escribe textos con inteligencia artificial

¿Cómo TorchScript optimiza el código de IA en PyTorch?

TorchScript es una herramienta clave en PyTorch que permite convertir modelos de inteligencia artificial escritos en Python a un formato independiente e interpretable, lo que facilita su optimización y despliegue en entornos de producción. Al compilar el código a través de TorchScript, se logra una ejecución más eficiente, reduciendo la sobrecarga de Python y permitiendo mejoras en el rendimiento. Esta optimización es esencial para aplicaciones que requieren baja latencia y alto rendimiento, como el procesamiento de imágenes o el análisis de lenguaje natural.

1. Beneficios de usar TorchScript en modelos de IA

TorchScript ofrece múltiples ventajas para los desarrolladores que trabajan con PyTorch. Entre ellas, destaca la capacidad de serializar modelos, lo que permite su uso en entornos sin dependencias de Python. Además, mejora la velocidad de ejecución al eliminar la interpretación en tiempo real y facilita la integración con sistemas escritos en otros lenguajes como C++.

| Beneficio | Descripción |

|---|---|

| Serialización | Permite guardar y cargar modelos sin código Python original. |

| Optimización | Reduce la sobrecarga de Python para una ejecución más rápida. |

| Portabilidad | Funciona en entornos sin Python, como aplicaciones móviles o embebidos. |

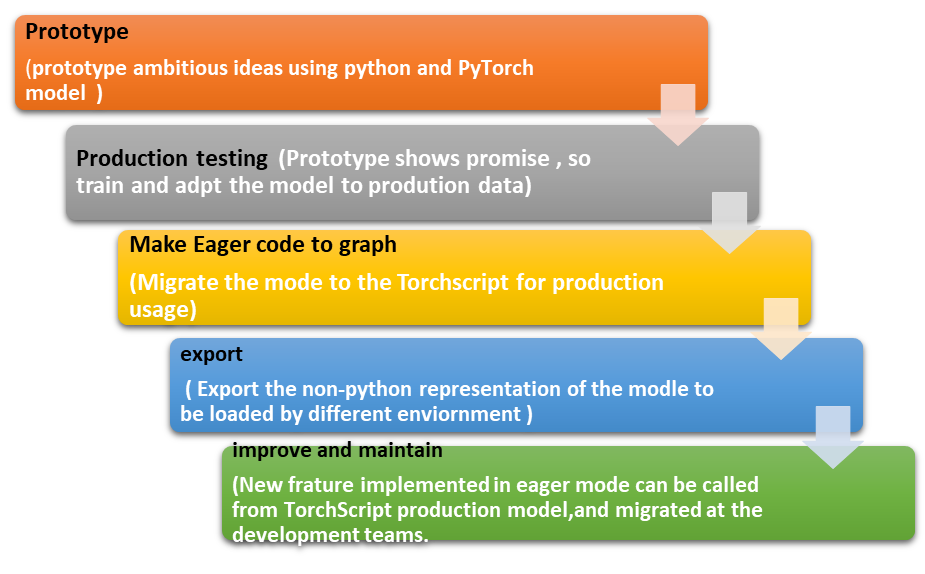

2. Pasos para convertir un modelo PyTorch a TorchScript

La conversión de un modelo PyTorch a TorchScript se realiza mediante dos métodos principales: tracing y scripting. El tracing captura las operaciones ejecutadas en un modelo usando un ejemplo de entrada, mientras que el scripting convierte directamente el código Python en TorchScript, ideal para modelos con flujos de control complejos.

| Método | Uso recomendado |

|---|---|

| Tracing | Modelos con operaciones estáticas y sin condicionales. |

| Scripting | Modelos con lógica condicional o bucles. |

3. Casos de uso donde TorchScript marca la diferencia

TorchScript es especialmente útil en escenarios donde el rendimiento y la eficiencia son críticos. Por ejemplo, en aplicaciones de edge computing, donde los recursos son limitados, o en servicios en la nube que requieren escalabilidad. Su capacidad para optimizar el código lo hace ideal para sistemas de recomendación, procesamiento de señales y visión por computadora.

| Caso de uso | Ventaja clave |

|---|---|

| Edge AI | Ejecución eficiente en dispositivos con recursos limitados. |

| Procesamiento de lenguaje natural | Reducción de latencia en inferencia de modelos grandes. |

| Cloud Deployment | Facilita la escalabilidad y carga de trabajo distribuida. |

¿Cuál es la diferencia entre Pytorch y Torchscript?

¿Qué es PyTorch?

PyTorch es un framework de aprendizaje profundo de código abierto basado en Python, desarrollado por Facebook. Está diseñado para facilitar la creación y entrenamiento de modelos de redes neuronales, ofreciendo flexibilidad y una interfaz intuitiva. PyTorch utiliza tensores y permite la ejecución dinámica de gráficos computacionales, lo que lo hace ideal para investigación y prototipado rápido.

- Flexibilidad: Permite modificar modelos sobre la marcha gracias a su gráfico dinámico.

- Interfaz Python: Se integra fácilmente con el ecosistema de Python, como NumPy y SciPy.

- Comunidad activa: Amplia documentación y soporte debido a su popularidad en investigación.

¿Qué es TorchScript?

TorchScript es una representación intermedia de modelos de PyTorch que permite su serialización y optimización. Está diseñado para convertir modelos escritos en PyTorch a un formato independiente de Python, facilitando su despliegue en entornos donde Python no está disponible, como dispositivos móviles o sistemas embebidos.

- Independencia de Python: Los modelos se ejecutan fuera del intérprete de Python, mejorando el rendimiento.

- Optimización: Permite aplicar técnicas de compilación para acelerar la inferencia.

- Portabilidad: Ideal para despliegue en producción en entornos restrictivos.

Diferencias clave entre PyTorch y TorchScript

La principal diferencia radica en su propósito y uso: PyTorch es un entorno de desarrollo completo, mientras que TorchScript es una herramienta para exportar y optimizar modelos creados en PyTorch. PyTorch es ideal para investigación, mientras que TorchScript se enfoca en producción.

- Ejecución: PyTorch requiere Python; TorchScript no.

- Flexibilidad vs. Rendimiento: PyTorch permite cambios dinámicos; TorchScript prioriza velocidad.

- Uso: PyTorch para prototipado; TorchScript para despliegue.

¿Qué se puede hacer con PyTorch?

Desarrollo de modelos de aprendizaje profundo

PyTorch es una herramienta esencial para construir y entrenar modelos de aprendizaje profundo. Su flexibilidad y facilidad de uso lo hacen ideal para investigadores y desarrolladores. Algunas aplicaciones incluyen:

- Redes neuronales convolucionales (CNN): Usadas en visión por computadora para tareas como clasificación de imágenes.

- Redes neuronales recurrentes (RNN): Ideales para procesamiento de lenguaje natural (NLP) y series temporales.

- Modelos transformadores: Base de arquitecturas como BERT o GPT, utilizadas en NLP avanzado.

Investigación y prototipado rápido

PyTorch es ampliamente utilizado en entornos académicos y de investigación debido a su capacidad para prototipado rápido. Características clave son:

- Ejecución en tiempo real: Gracias a su modo eager execution, permite depuración interactiva.

- Integración con bibliotecas científicas: Compatible con NumPy, SciPy y otras herramientas de análisis de datos.

- Personalización de capas y funciones: Facilita la creación de componentes personalizados para experimentos únicos.

Despliegue de modelos en producción

PyTorch no solo es útil en investigación, sino también en entornos de producción. Herramientas como TorchScript y ONNX permiten:

- Optimización de modelos: Conversión a formatos eficientes para inferencia en dispositivos móviles o servidores.

- Integración con sistemas empresariales: Uso en pipelines de datos o aplicaciones en la nube.

- Escalabilidad: Soporte para distribuir entrenamiento en múltiples GPUs o clusters.

¿Cómo escribir un optimizador de PyTorch?

¿Qué es un optimizador en PyTorch?

Un optimizador en PyTorch es una clase que implementa algoritmos para ajustar los parámetros de un modelo durante el entrenamiento, minimizando la función de pérdida. PyTorch incluye optimizadores populares como SGD, Adam o RMSprop, pero también permite crear personalizados. Para escribir uno, es necesario entender:

- El gradiente de los parámetros, calculado durante el backpropagation.

- La lógica del algoritmo de optimización (ej: actualización de pesos).

- La integración con el ciclo de entrenamiento de PyTorch.

Estructura básica de un optimizador personalizado

Un optimizador personalizado en PyTorch debe heredar de la clase torch.optim.Optimizer e implementar el método step(). Aquí los componentes clave:

- Inicialización: Definir los parámetros a optimizar y hyperparámetros (ej: tasa de aprendizaje).

- Método step(): Contiene la lógica para actualizar los parámetros usando sus gradientes.

- Método zero_grad(): Opcional, pero útil para reiniciar gradientes antes de cada iteración.

Ejemplo práctico: Implementar un optimizador SGD simple

Para crear una versión básica del descenso de gradiente estocástico (SGD), sigue estos pasos:

- Define una clase que herede de Optimizer y reciba los parámetros del modelo y la tasa de aprendizaje (lr).

- En el método step(), itera sobre los parámetros y aplica la regla de actualización: param -= lr param.grad.

- Usa el optimizador en el ciclo de entrenamiento llamando a step() después de backward().

¿Qué es pytorch torchscript?

¿Qué es PyTorch TorchScript?

PyTorch TorchScript es una forma de convertir modelos de PyTorch en un formato independiente de Python, lo que permite su ejecución en entornos donde Python no está disponible. TorchScript proporciona un subconjunto estático del lenguaje Python, optimizado para inferencia y despliegue en producción. Esto facilita la integración en aplicaciones móviles, servidores o dispositivos embebidos.

- Serialización: Permite guardar modelos en un formato que puede ser cargado sin el código original.

- Optimización: Incluye técnicas como fusión de operaciones para mejorar el rendimiento.

- Portabilidad: Funciona en entornos sin Python, como C++ o sistemas embebidos.

Ventajas de usar TorchScript

Las principales ventajas de TorchScript incluyen la capacidad de ejecutar modelos en entornos de alto rendimiento y la compatibilidad con múltiples plataformas. Además, permite una mayor eficiencia en la inferencia y reduce la dependencia de Python.

- Rendimiento mejorado: Elimina la sobrecarga de Python durante la inferencia.

- Compatibilidad multiplataforma: Se ejecuta en servidores, móviles y dispositivos IoT.

- Facilidad de despliegue: Simplifica la integración en aplicaciones empresariales.

¿Cómo convertir un modelo a TorchScript?

Para convertir un modelo de PyTorch a TorchScript, se utilizan métodos como tracing o scripting. El tracing sigue la ejecución del modelo con un ejemplo de entrada, mientras que scripting analiza directamente el código Python.

- Tracing: Usa

torch.jit.tracepara capturar las operaciones del modelo. - Scripting: Emplea

torch.jit.scriptpara modelos con flujos de control complejos. - Validación: Verifica que el modelo convertido produzca los mismos resultados que el original.

Mas Información sobre este tema

¿Qué es TorchScript y cómo optimiza el código de IA en PyTorch?

TorchScript es una herramienta de PyTorch que permite convertir modelos de inteligencia artificial escritos en Python en un formato intermedio independiente de Python, optimizado para ejecución eficiente. Al compilar el código a TorchScript, se logra una mayor velocidad de inferencia, portabilidad y la capacidad de ejecutarse en entornos donde Python no está disponible. Esto es especialmente útil para despliegues en producción, ya que reduce la sobrecarga del intérprete de Python y permite optimizaciones adicionales como fusiones de operaciones y paralelización.

¿Cuáles son las ventajas de usar TorchScript frente a PyTorch estándar?

La principal ventaja de TorchScript es su capacidad para mejorar el rendimiento en entornos de producción. Al ser un formato estático y precompilado, elimina la dependencia de Python durante la inferencia, lo que reduce la latencia y el consumo de recursos. Además, facilita la integración en sistemas escritos en otros lenguajes como C++ gracias a su compatibilidad con la API de LibTorch. También permite optimizaciones avanzadas, como la eliminación de código redundante y la optimización de operaciones matriciales, lo que lo hace ideal para aplicaciones de baja latencia o edge computing.

¿Cómo se convierte un modelo de PyTorch a TorchScript?

Para convertir un modelo de PyTorch a TorchScript, existen dos métodos principales: tracing y scripting. El tracing registra las operaciones ejecutadas durante un pase frontal con datos de ejemplo, generando un grafo estático, pero no admite flujos de control dinámicos. El scripting, por otro lado, analiza directamente el código Python y lo convierte en TorchScript, preservando estructuras como bucles y condicionales. Una vez convertido, el modelo puede guardarse en un archivo .pt o .pth y cargarse posteriormente sin necesidad del código original, lo que simplifica su despliegue.

Esto es de tu interes IBM Watson integra IA en apps empresariales

IBM Watson integra IA en apps empresariales Core ML crea modelos de IA para apps de iOS

Core ML crea modelos de IA para apps de iOS Kubeflow automatiza flujos de IA en Kubernetes

Kubeflow automatiza flujos de IA en KubernetesSi quieres conocer otros artículos parecidos a TorchScript optimiza código de IA con PyTorch puedes visitar la categoría IA para Desarrolladores.

Deja una respuesta

Contenido Relacionado