Stable Diffusion 3 mejora imágenes con IA

- Stable Diffusion 3: La revolución de la IA en el mejoramiento de imágenes

- ¿Cuáles son las limitaciones de la difusión estable 3?

- ¿Qué es mejor, midjourney or Stable Diffusion?

- ¿Cuál es la resolución de la difusión estable 3?

- ¿Cuántas imágenes se necesitan para entrenar la difusión estable?

- Mas Información sobre este tema

La inteligencia artificial continúa revolucionando el campo de la generación de imágenes, y Stable Diffusion 3 marca un nuevo hito en esta evolución. Esta última versión del modelo de difusión estable promete mejoras significativas en la calidad, el realismo y la coherencia de las imágenes generadas. Con avances en el procesamiento del lenguaje natural y una arquitectura optimizada, la herramienta permite a usuarios crear visuales más detallados y precisos con solo unas pocas indicaciones.

Stable Diffusion 3 no solo eleva el estándar de la creatividad asistida por IA, sino que también democratiza el acceso a tecnología avanzada. Desde artistas digitales hasta diseñadores profesionales, cualquier persona puede aprovechar sus capacidades para producir contenido visual impactante. Las mejoras en la comprensión de prompts y la reducción de artefactos indeseados hacen que esta versión sea una de las más versátiles y confiables hasta la fecha.

Stable Diffusion 3: La revolución de la IA en el mejoramiento de imágenes

¿Cómo funciona Stable Diffusion 3 para mejorar imágenes?

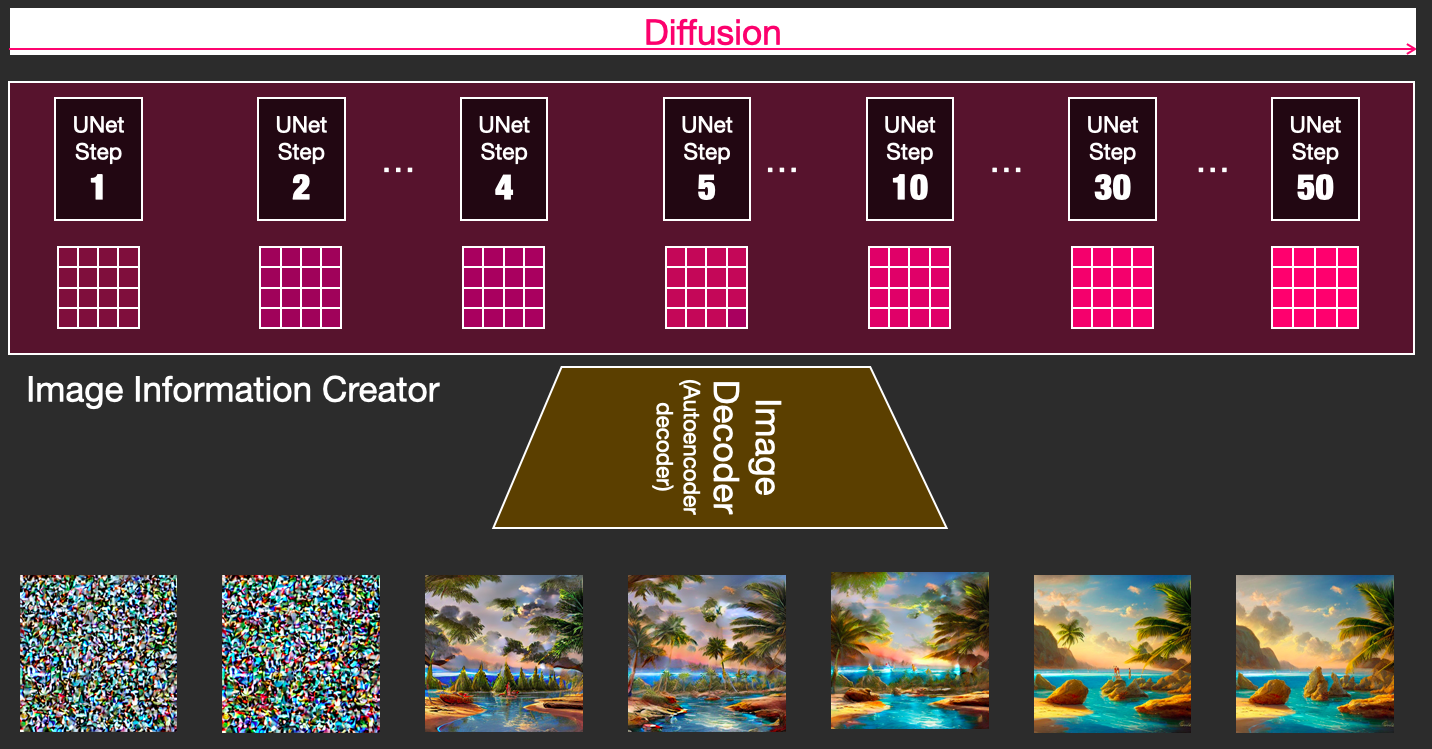

Stable Diffusion 3 utiliza algoritmos avanzados de inteligencia artificial para analizar y optimizar imágenes pixel por pixel. A diferencia de versiones anteriores, esta nueva iteración emplea redes neuronales más profundas y conjuntos de datos más amplios, lo que le permite corregir imperfecciones, aumentar la resolución y ajustar colores con mayor precisión. Su capacidad de aprendizaje automático le permite entender el contexto de la imagen, evitando distorsiones no deseadas.

| Característica | Mejora en Stable Diffusion 3 |

|---|---|

| Resolución | Ampliación de imágenes sin pérdida de calidad |

| Corrección de color | Ajuste automático de balance de blancos y saturación |

| Reducción de ruido | Eliminación de artefactos en fotos de baja luz |

Ventajas de usar Stable Diffusion 3 frente a otras herramientas de IA

Este modelo destaca por su velocidad de procesamiento y resultados más naturales en comparación con alternativas como MidJourney o DALL-E. Su arquitectura optimizada consume menos recursos, permitiendo su uso en hardware menos potente. Además, ofrece mayor control mediante prompts detallados, lo que reduce la necesidad de retoques manuales. Es especialmente eficaz en fotografía, diseño gráfico y restauración de imágenes antiguas.

| Herramienta | Diferencial de Stable Diffusion 3 |

|---|---|

| MidJourney | Mayor realismo en detalles finos |

| DALL-E 3 | Mejor conservación de elementos originales |

| Photoshop IA | Procesamiento local sin necesidad de nube |

Aplicaciones prácticas de Stable Diffusion 3 en proyectos creativos

Desde profesionales hasta aficionados pueden beneficiarse de sus funciones. Los diseñadores web pueden optimizar banners, los fotógrafos restaurar archivos dañados, y los artistas digitales generar bases para sus obras. Su integración con herramientas como Blender o After Effects abre posibilidades para preproducción audiovisual. También es útil en educación, permitiendo revitalizar material histórico visual con fines didácticos.

| Ámbito | Uso concreto |

|---|---|

| Marketing digital | Creación de variantes de imágenes para A/B testing |

| Arqueología | Reconstrucción de artefactos visuales deteriorados |

| Medicina | Mejora de imágenes microscópicas para diagnóstico |

¿Cuáles son las limitaciones de la difusión estable 3?

Limitaciones en la generación de imágenes complejas

La difusión estable 3 puede enfrentar dificultades al generar imágenes con altos niveles de detalle o composiciones muy elaboradas. Algunas de estas limitaciones incluyen:

- Falta de precisión en elementos pequeños o texturas finas, como cabello o patrones repetitivos.

- Dificultad para interpretar escenas con múltiples objetos interactuando, lo que puede resultar en superposiciones incoherentes.

- Problemas al mantener la coherencia espacial en imágenes con perspectivas complejas o fondos detallados.

Restricciones en el procesamiento de texto a imagen

Al convertir descripciones textuales en imágenes, el modelo puede mostrar las siguientes debilidades:

- Interpretación literal de prompts ambiguos, generando resultados no deseados o abstractos.

- Limitaciones para integrar contexto cultural o estilos artísticos muy específicos sin ejemplos claros.

- Dificultad al manejar instrucciones largas o contradictorias, priorizando solo partes del texto.

Desafíos técnicos y de recursos

La implementación de la difusión estable 3 también enfrenta barreras relacionadas con su infraestructura y rendimiento:

- Alto consumo computacional, requiriendo hardware potente para generar imágenes en tiempos razonables.

- Limitaciones en la resolución nativa, necesitando post-procesamiento para escalar imágenes sin perder calidad.

- Dependencia de datos de entrenamiento, lo que puede generar sesgos o lagunas en temas poco representados.

¿Qué es mejor, midjourney or Stable Diffusion?

Comparación de calidad de imágenes entre MidJourney y Stable Diffusion

La calidad de las imágenes generadas por MidJourney suele ser más artística y detallada, especialmente en estilos como el surrealismo o el arte conceptual. Por otro lado, Stable Diffusion ofrece mayor control técnico y adaptabilidad para usuarios avanzados. Aquí algunas diferencias clave:

- MidJourney destaca en generar resultados más coherentes y estéticamente atractivos sin necesidad de ajustes profundos.

- Stable Diffusion permite modificar parámetros como el ruido o los modelos personalizados para lograr resultados específicos.

- La elección depende del uso: arte rápido (MidJourney) vs. experimentación técnica (Stable Diffusion).

Facilidad de uso y accesibilidad

MidJourney opera principalmente a través de Discord, lo que simplifica su uso pero limita el acceso sin conexión. Stable Diffusion, en cambio, puede ejecutarse localmente o en la nube, ofreciendo más flexibilidad. Aspectos a considerar:

- Interfaz: MidJourney es más amigable para principiantes, mientras que Stable Diffusion requiere conocimientos técnicos.

- Coste: MidJourney tiene un modelo de suscripción, mientras que Stable Diffusion es gratuito en su versión básica.

- Requisitos: Stable Diffusion necesita hardware potente para correr localmente, MidJourney solo requiere una cuenta en Discord.

Personalización y control creativo

Si buscas personalización avanzada, Stable Diffusion es superior gracias a sus modelos personalizables (LoRAs, checkpoints) y herramientas como ControlNet. MidJourney, aunque limitado, ofrece estilos predefinidos eficaces. Puntos clave:

- Stable Diffusion permite entrenar modelos propios y ajustar hiperparámetros.

- MidJourney optimiza la generación con estilos preestablecidos (--v 5, --niji).

- Integración con otras herramientas: Stable Diffusion funciona con Automatic1111 o ComfyUI para flujos de trabajo complejos.

¿Cuál es la resolución de la difusión estable 3?

La resolución de la difusión estable 3 generalmente se refiere a la versión más reciente y optimizada de un software o sistema, diseñada para ofrecer un rendimiento estable y sin errores críticos. Esta versión suele incluir correcciones de bugs, mejoras de seguridad y optimizaciones de rendimiento.

Características principales de la difusión estable 3

La difusión estable 3 incorpora varias mejoras clave para garantizar un funcionamiento fluido y seguro.

- Corrección de errores: Se han solucionado problemas conocidos en versiones anteriores.

- Mejoras de rendimiento: Optimización en la velocidad y eficiencia del sistema.

- Actualizaciones de seguridad: Parches para vulnerabilidades identificadas.

Requisitos técnicos para la difusión estable 3

Para ejecutar la difusión estable 3, es necesario cumplir con ciertos requisitos mínimos del sistema.

- Sistema operativo compatible: Windows 10/11, macOS 12+, o Linux (distribuciones soportadas).

- Hardware: Mínimo 4GB de RAM y 10GB de espacio en disco.

- Conectividad: Conexión a Internet para actualizaciones automáticas.

Ventajas de actualizar a la difusión estable 3

Actualizar a esta versión ofrece múltiples beneficios para usuarios y desarrolladores.

- Mayor estabilidad: Reducción de fallos y cierres inesperados.

- Nuevas funciones: Incorporación de herramientas y opciones mejoradas.

- Soporte prolongado: Acceso a actualizaciones y asistencia técnica.

¿Cuántas imágenes se necesitan para entrenar la difusión estable?

Factores que determinan la cantidad de imágenes necesarias

La cantidad de imágenes requeridas para entrenar un modelo de difusión estable depende de varios factores clave. A continuación, se detallan los más relevantes:

- Complejidad del dataset: Si las imágenes son muy diversas (ej. múltiples objetos, estilos o escenas), se necesitará un volumen mayor para cubrir todas las variaciones.

- Calidad de las imágenes: Datos con alta resolución y sin ruido permiten un entrenamiento más eficiente, reduciendo la cantidad necesaria.

- Objetivo del modelo: Aplicaciones especializadas (ej. generación de rostros humanos) pueden requerir menos imágenes que modelos genéricos.

Rangos típicos para entrenamiento básico y avanzado

El número de imágenes varía según el nivel de sofisticación del modelo. Aquí algunos ejemplos:

- Entrenamiento básico: Entre 10,000 y 50,000 imágenes para tareas simples con baja diversidad.

- Modelos intermedios: De 100,000 a 500,000 imágenes para aplicaciones como generación de arte o fotos realistas.

- Proyectos de alta gama: Más de 1 millón de imágenes para sistemas que emulan múltiples estilos o dominios complejos.

Optimización del tamaño del dataset

Reducir la cantidad de imágenes sin comprometer el rendimiento es posible con técnicas específicas:

- Aumento de datos: Rotaciones, recortes o cambios de color para multiplicar artificialmente las muestras.

- Transfer learning: Usar modelos preentrenados y ajustarlos con un subconjunto más pequeño de imágenes.

- Selección cuidadosa: Eliminar duplicados o imágenes irrelevantes para mejorar la calidad del dataset.

Mas Información sobre este tema

¿Cómo mejora Stable Diffusion 3 la calidad de las imágenes con IA?

Stable Diffusion 3 utiliza algoritmos avanzados de inteligencia artificial para analizar y optimizar imágenes pixeladas o de baja resolución. A diferencia de versiones anteriores, esta actualización emplea modelos de aprendizaje profundo más potentes, capaces de reconstruir detalles finos, reducir el ruido y ajustar colores de manera automática. Además, incorpora técnicas como el super-resolución y el relleno de contextos para generar resultados más realistas y coherentes.

¿Qué diferencias hay entre Stable Diffusion 3 y otras herramientas de mejora de imágenes?

La principal ventaja de Stable Diffusion 3 frente a otras herramientas es su capacidad para generar contenido nuevo mientras mejora la imagen original, gracias a su arquitectura basada en redes generativas adversarias (GANs) y transformadores difusivos. A diferencia de soluciones tradicionales que solo aplican filtros, esta versión interpreta el contexto de la imagen, permitiendo correcciones más inteligentes, como restaurar rostros borrosos o completar fondos faltantes sin perder naturalidad.

¿Es necesario tener conocimientos técnicos para usar Stable Diffusion 3?

No, Stable Diffusion 3 está diseñado para ser accesible tanto para usuarios avanzados como para principiantes. Incluye interfaces intuitivas y opciones preconfiguradas que automatizan el proceso de mejora. Sin embargo, quienes deseen ajustar parámetros manualmente, como la intensidad del difuminado o el nivel de detalle, pueden acceder a funciones avanzadas mediante paneles de control sencillos, sin requerir programación.

Esto es de tu interes ChatGPT 4o lidera tendencias en IA generativa

ChatGPT 4o lidera tendencias en IA generativa DALL·E 3 genera imágenes con IA avanzada

DALL·E 3 genera imágenes con IA avanzada Llama 3 impulsa modelos IA de código abierto

Llama 3 impulsa modelos IA de código abiertoSi quieres conocer otros artículos parecidos a Stable Diffusion 3 mejora imágenes con IA puedes visitar la categoría Novedades IA.

Deja una respuesta

Contenido Relacionado