DeepSpeed optimiza entrenamiento de IA con PyTorch

PyTorch, el avance en el campo de la inteligencia artificial requiere herramientas cada vez más eficientes para manejar modelos complejos. DeepSpeed, una biblioteca de optimización desarrollada por Microsoft, se ha posicionado como una solución clave para acelerar y mejorar el entrenamiento de modelos de IA utilizando PyTorch.

Gracias a sus técnicas avanzadas de paralelismo y gestión de memoria, DeepSpeed permite reducir significativamente el tiempo y los costos asociados al proceso de entrenamiento, incluso con conjuntos de datos masivos.

Esta tecnología es especialmente relevante en escenarios donde los recursos computacionales son limitados. DeepSpeed no solo optimiza el rendimiento, sino que también facilita la escalabilidad de modelos de aprendizaje profundo. Al integrarse de manera fluida con PyTorch, ofrece a los investigadores y desarrolladores la flexibilidad necesaria para implementar soluciones innovadoras sin sacrificar eficiencia. Su impacto está transformando la manera en que se entrenan modelos de IA, abriendo nuevas posibilidades en investigación y aplicaciones prácticas.

Te puede interesar leer: Darktrace detecta amenazas con IA avanzada

DeepSpeed: Optimización del Entrenamiento de IA con PyTorch

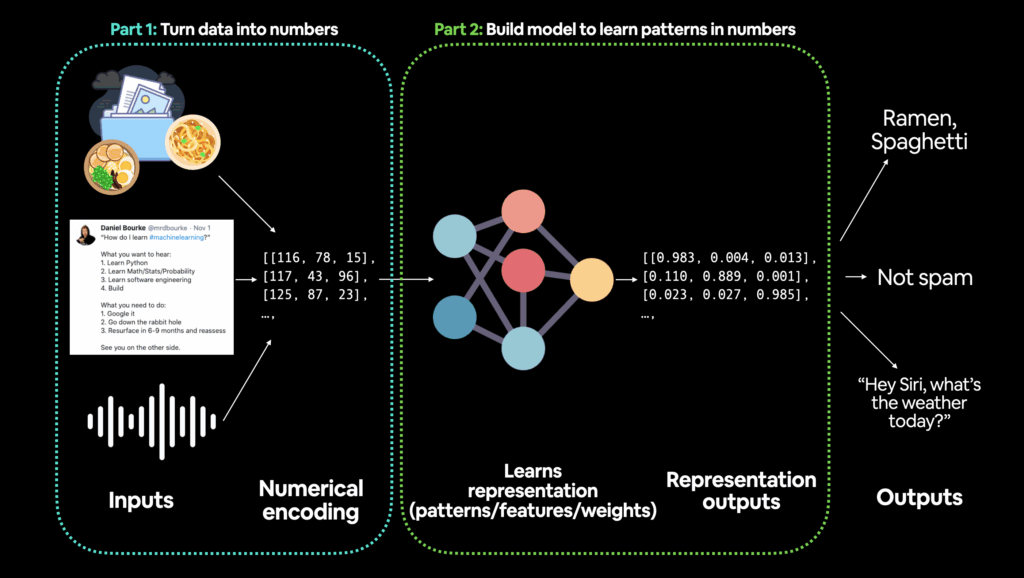

DeepSpeed es una biblioteca de optimización de código abierto desarrollada por Microsoft, diseñada para acelerar y mejorar la eficiencia del entrenamiento de modelos de inteligencia artificial, especialmente cuando se utiliza con PyTorch. Esta herramienta permite manejar modelos de gran escala con millones o incluso billones de parámetros, reduciendo el consumo de memoria y acelerando el proceso de entrenamiento. DeepSpeed es esencial para investigadores y desarrolladores que trabajan con modelos de IA complejos y necesitan maximizar el rendimiento sin sacrificar precisión.

¿Cómo DeepSpeed Acelera el Entrenamiento en PyTorch?

DeepSpeed implementa técnicas avanzadas como la paralelización de modelos, la gestión eficiente de la memoria y la compresión de gradientes. Una de sus características clave es el Zero Redundancy Optimizer (ZeRO), que elimina la redundancia en el almacenamiento de parámetros y optimiza el uso de recursos computacionales. Esto permite escalar modelos masivos sin requerir hardware excesivamente costoso.

| Técnica | Beneficio |

|---|---|

| Paralelización de modelos | Distribuye el modelo en múltiples GPUs |

| ZeRO (Zero Redundancy Optimizer) | Reduce el consumo de memoria hasta en un 90% |

| Compresión de gradientes | Disminuye la comunicación entre GPUs |

Ventajas de Usar DeepSpeed con PyTorch

La integración de DeepSpeed con PyTorch ofrece múltiples beneficios, como una mayor escalabilidad, menor tiempo de entrenamiento y compatibilidad con infraestructuras existentes. DeepSpeed permite entrenar modelos que antes eran imposibles de manejar debido a limitaciones de memoria. Además, su flexibilidad facilita la implementación en entornos distribuidos, lo que lo hace ideal para proyectos de investigación y producción.

| Ventaja | Impacto |

|---|---|

| Escalabilidad mejorada | Entrenamiento de modelos con billones de parámetros |

| Reducción de costos | Menor necesidad de hardware especializado |

| Compatibilidad con PyTorch | Integración sin cambios drásticos en el código |

Casos de Uso Comunes de DeepSpeed

DeepSpeed es ampliamente utilizado en el entrenamiento de modelos de lenguaje grandes (LLMs), como GPT-3, y en aplicaciones de visión por computadora. También es útil en entornos académicos y empresariales donde se requiere eficiencia computacional. Su capacidad para manejar grandes volúmenes de datos lo convierte en una solución preferida para proyectos de IA avanzada.

| Caso de Uso | Ejemplo |

|---|---|

| Modelos de Lenguaje (LLMs) | Entrenamiento de GPT-3 y modelos similares |

| Visión por Computadora | Procesamiento de imágenes a gran escala |

| Investigación Académica | Experimentación con arquitecturas novedosas |

Mas Información sobre este tema

¿Qué es DeepSpeed y cómo optimiza el entrenamiento de modelos de IA con PyTorch?

DeepSpeed es una biblioteca de optimización de código abierto desarrollada por Microsoft, diseñada para acelerar y mejorar la eficiencia del entrenamiento de modelos de IA, especialmente cuando se trabaja con PyTorch. Esta herramienta permite reducir el consumo de memoria y acelerar los tiempos de entrenamiento mediante técnicas avanzadas como paralelismo de datos y modelos, gestión eficiente de la memoria y optimización de gradientes. Además, DeepSpeed incluye funciones como ZeRO (Zero Redundancy Optimizer), que elimina redundancias en el almacenamiento de estados del optimizador, permitiendo escalar modelos masivos con menos recursos.

¿Cuáles son las principales ventajas de usar DeepSpeed con PyTorch?

Las ventajas clave de integrar DeepSpeed con PyTorch incluyen una mayor escalabilidad para modelos grandes, una reducción significativa en el uso de memoria y la capacidad de entrenar modelos con miles de millones de parámetros en hardware limitado. También ofrece soporte para múltiples GPUs y clusters distribuidos, optimizando la comunicación entre dispositivos para minimizar cuellos de botella. Otra ventaja destacable es su compatibilidad con técnicas de compresión de gradientes y checkpointing, que permiten continuar entrenamientos interrumpidos sin perder progreso.

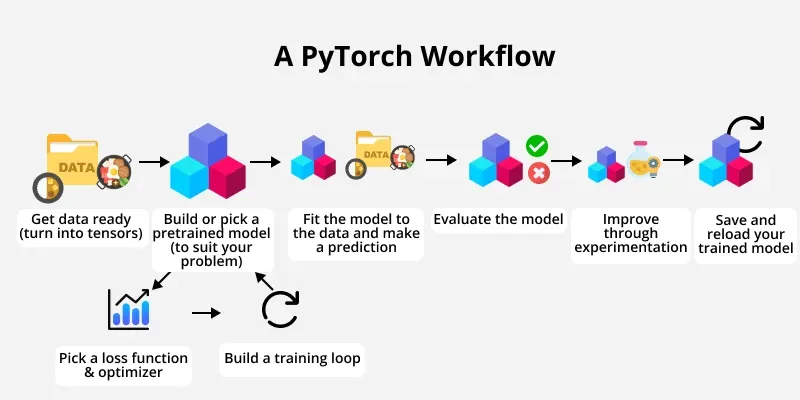

¿Cómo se implementa DeepSpeed en un proyecto existente de PyTorch?

Implementar DeepSpeed en un proyecto de PyTorch es relativamente sencillo gracias a su integración nativa. Primero, se debe instalar la biblioteca mediante pip o conda. Luego, se configura un archivo JSON que define parámetros como el tamaño de lote, optimizadores y ajustes de paralelismo. El siguiente paso es modificar el código de entrenamiento para utilizar el DeepSpeed Engine, que reemplaza el bucle tradicional de PyTorch. Finalmente, se lanza el entrenamiento con un script que invoca DeepSpeed, aprovechando sus optimizaciones sin necesidad de reescribir el modelo desde cero. La documentación oficial proporciona ejemplos detallados para adaptar proyectos existentes.

Esto es de tu interes Megatron-LM entrena modelos de IA masivos

Megatron-LM entrena modelos de IA masivos Triton Inference ejecuta modelos de IA en apps

Triton Inference ejecuta modelos de IA en apps NeMo de NVIDIA crea IA conversacional

NeMo de NVIDIA crea IA conversacionalSi quieres conocer otros artículos parecidos a DeepSpeed optimiza entrenamiento de IA con PyTorch puedes visitar la categoría IA para Desarrolladores.

Deja una respuesta

Contenido Relacionado